使用Tensorflow在For循环中创建神经网络

我正在尝试从包含所需网络结构的列表中使用Tensorflow在for循环中创建一个简单的MLP。结构= [100,50,20,1]。在此列表中,100代表输入大小,1代表输出大小。 (我将其用于预测应用程序,但这与我的问题并不严格相关。)

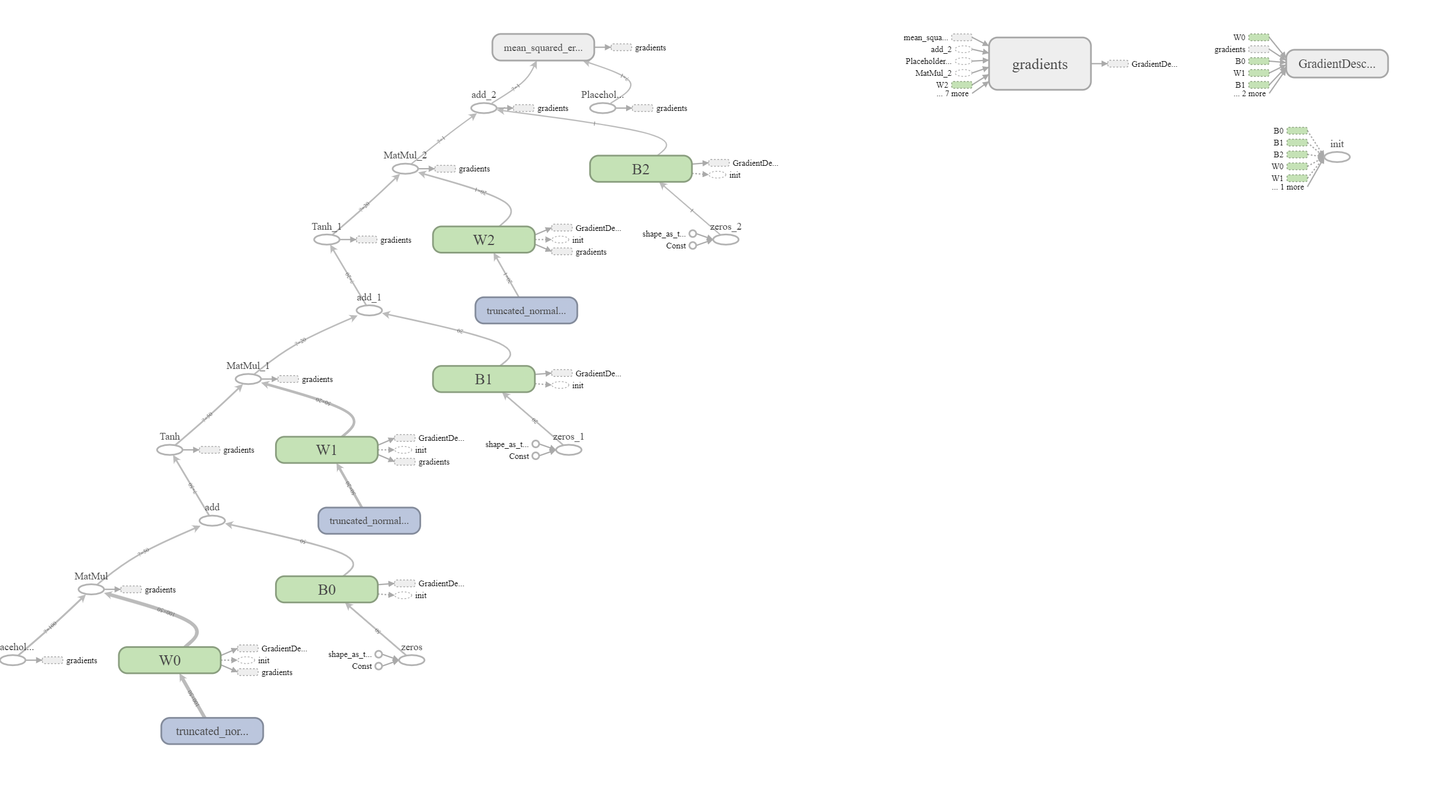

我还没有看到类似的方法来在Tensorflow中创建网络。出于部分原因,人们似乎建议最好单独声明每个变量,例如layer_1 = x1 * w1 + b1,然后layer_2 = x2 * w2 + b2。动态创建网络的方法是否在for循环中使用[for range(len(structure)-1):] :)?对我来说,网络似乎运行良好,并且张量板上显示的网络结构似乎是正确的。

您认为这种创建网络的方式很好吗?您是否认为我在不知不觉中遇到任何Tensorflow / Context Manager问题?

import tensorflow as tf

class Model(object):

def __init__(self, structure, lr=0.01):

assert structure[-1] == 1

input_size = structure[0]

act_fun = tf.nn.tanh

G = tf.Graph()

with G.as_default():

self.X = tf.placeholder(tf.float32, shape=[None, input_size])

self.Y = tf.placeholder(tf.float32, shape=[None, 1])

X_out = self.X

for i in range(len(structure)-1):

from_, to = structure[i], structure[i+1]

initializer = tf.variance_scaling_initializer()

w = tf.Variable(initializer([from_, to]), dtype=tf.float32, name=f'W{i}')

b = tf.Variable(tf.zeros(to), name=f'B{i}')

if to != 1:

X_out = act_fun(tf.matmul(X_out, w) + b)

else:

X_out = tf.matmul(X_out, w) + b

self.forecast_layer = X_out

self.loss = tf.losses.mean_squared_error(self.Y, self.forecast_layer)

self.trainer = tf.train.GradientDescentOptimizer(lr).minimize(self.loss)

self.init = tf.global_variables_initializer()

self.session = tf.Session(graph=G)

self.session.run(self.init)

self.session.graph.finalize()

def fit(self, X, Y):

self.session.run(self.trainer, feed_dict={self.X:X, self.Y:Y})

def forecast(self, X):

return self.forecast_layer.eval(feed_dict={self.X:X}, session=self.session)

def evaluate_loss(self, X, Y):

return self.loss.eval(feed_dict={self.Y:Y, self.forecast_layer:self.forecast(X)}, session=self.session)

M = Model([100, 50, 20, 1], lr=0.001)

1 个答案:

答案 0 :(得分:0)

虽然我会使用tf.layers.dense,但这似乎很好:

X_out = self.X

layers = [50, 20, 1]

for layer_size in layers:

X_out = tf.layers.dense(X_out, layer_size, activation=act_fun if x != 1 else None)

注意:

警告:不建议使用此功能。它将在将来的版本中删除。更新说明:改用keras.layers.dense。

相关问题

最新问题

- 我写了这段代码,但我无法理解我的错误

- 我无法从一个代码实例的列表中删除 None 值,但我可以在另一个实例中。为什么它适用于一个细分市场而不适用于另一个细分市场?

- 是否有可能使 loadstring 不可能等于打印?卢阿

- java中的random.expovariate()

- Appscript 通过会议在 Google 日历中发送电子邮件和创建活动

- 为什么我的 Onclick 箭头功能在 React 中不起作用?

- 在此代码中是否有使用“this”的替代方法?

- 在 SQL Server 和 PostgreSQL 上查询,我如何从第一个表获得第二个表的可视化

- 每千个数字得到

- 更新了城市边界 KML 文件的来源?