从AWS Kinesis firehose到AWS S3写拼花

我想从kinesis firehose格式化为镶木地板的数据中摄取数据。到目前为止,我刚刚找到一个解决方案,意味着创建一个EMR,但我正在寻找更便宜和更快的东西,如直接从firehose存储收到的json作为镶木地板或使用Lambda函数。

非常感谢, 哈维。

2 个答案:

答案 0 :(得分:19)

在处理AWS支持服务和一百种不同的实现后,我想解释一下我所取得的成就。

最后,我创建了一个Lambda函数,用于处理Kinesis Firehose生成的每个文件,根据有效负载对事件进行分类,并将结果存储在S3中的Parquet文件中。

这样做并不容易:

-

首先,您应该创建一个Python虚拟环境,包括所有必需的库(在我的例子中是Pandas,NumPy,Fastparquet等)。 由于结果文件(包括所有库和我的Lambda函数很重,因此需要启动EC2实例,我使用了免费层中包含的那个)。要创建虚拟环境,请执行以下步骤:

- 以EC2登录

- 创建名为lambda(或任何其他名称)的文件夹

- Sudo yum -y update

- Sudo yum -y upgrade

- sudo yum -y groupinstall“开发工具”

- sudo yum -y install blas

- sudo yum -y install lapack

- sudo yum -y install atlas-sse3-devel

- sudo yum install python27-devel python27-pip gcc

- Virtualenv env

- source env / bin / activate

- pip install boto3

- pip install fastparquet

- pip install pandas

- pip install thriftpy

- pip install s3fs

- pip install(任何其他必需的库)

- find~ / lambda / env / lib * / python2.7 / site-packages / -name“* .so”| xargs strip

- pushd env / lib / python2.7 / site-packages /

- zip -r -9 -q~ / lambda.zip *

- Popd的

- pushd env / lib64 / python2.7 / site-packages /

- zip -r -9 -q~ / lambda.zip *

- Popd的

-

创建lambda_function属性:

import json import boto3 import datetime as dt import urllib import zlib import s3fs from fastparquet import write import pandas as pd import numpy as np import time def _send_to_s3_parquet(df): s3_fs = s3fs.S3FileSystem() s3_fs_open = s3_fs.open # FIXME add something else to the key or it will overwrite the file key = 'mybeautifullfile.parquet.gzip' # Include partitions! key1 and key2 write( 'ExampleS3Bucket'+ '/key1=value/key2=othervalue/' + key, df, compression='GZIP',open_with=s3_fs_open) def lambda_handler(event, context): # Get the object from the event and show its content type bucket = event['Records'][0]['s3']['bucket']['name'] key = urllib.unquote_plus(event['Records'][0]['s3']['object']['key']) try: s3 = boto3.client('s3') response = s3.get_object(Bucket=bucket, Key=key) data = response['Body'].read() decoded = data.decode('utf-8') lines = decoded.split('\n') # Do anything you like with the dataframe (Here what I do is to classify them # and write to different folders in S3 according to the values of # the columns that I want df = pd.DataFrame(lines) _send_to_s3_parquet(df) except Exception as e: print('Error getting object {} from bucket {}.'.format(key, bucket)) raise e -

将lambda函数复制到lambda.zip并部署lambda_function:

- 返回您的EC2实例并将zip所需的lambda函数添加到zip:zip -9 lambda.zip lambda_function.py(lambda_function.py是步骤2中生成的文件)

- 将生成的zip文件复制到S3,因为通过S3进行部署非常繁重。 aws s3 cp lambda.zip s3:// support-bucket / lambda_packages /

- 部署lambda函数:aws lambda update-function-code --function-name --s3-bucket support-bucket --s3-key lambda_packages / lambda.zip

-

在您喜欢时触发要执行的操作,例如,每次在S3中创建新文件,或者甚至可以将lambda函数与Firehose相关联。 (我没有选择此选项,因为'lambda'限制低于Firehose限制,你可以配置Firehose每128Mb或15分钟写一个文件,但是如果你将这个lambda函数关联到Firehose,lambda函数将被执行每3分钟或5MB,在我的情况下,我有生成很多小镶木地板文件的问题,因为每次启动lambda函数我生成至少10个文件)。

答案 1 :(得分:9)

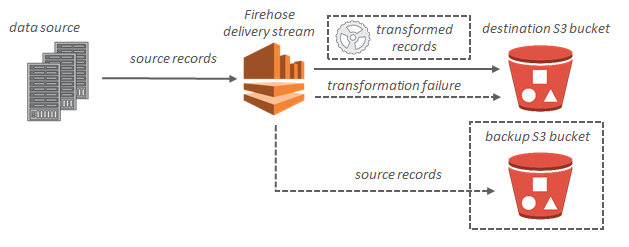

Amazon Kinesis Firehose接收流媒体记录,并可将其存储在Amazon S3(或Amazon Redshift或Amazon Elasticsearch Service)中。

每条记录最多可达1000KB。

但是,记录会附加到文本文件中,并根据时间或大小进行批处理。传统上,记录是JSON格式。

您将无法发送镶木地板文件,因为它不符合此文件格式。

可以触发Lambda数据转换功能,但这也不能输出镶木地板文件。

事实上,鉴于镶木地板文件的性质,您不可能一次一条记录。作为一种柱状存储格式,我怀疑它们确实需要在批处理中创建,而不是每个记录都附加数据。

底线:没有。

- 从kinesis写下镶木地板文件

- 我可以自动将换行添加到AWS Firehose记录吗?

- 从AWS Kinesis firehose到AWS S3写拼花

- AWS:设置从PostgreSQL到Redshift的kinesis流

- 从亚马逊sqs读取数据并以Parquet格式写入s3

- 使用AWS Kinesis Firehose写入S3存储桶中的特定文件夹

- AWS Kinesis firehose-每个用户的第一个活动时间

- 将一个aws帐户拥有的s3的写访问权设置为另一个aws帐户所拥有的firehose流

- AWS Glue-如何从S3抓取Kinesis Firehose输出文件夹

- 使用AWS Firehose传递S3“键”参数-需要此参数才能在S3存储桶中创建文件夹结构

- 我写了这段代码,但我无法理解我的错误

- 我无法从一个代码实例的列表中删除 None 值,但我可以在另一个实例中。为什么它适用于一个细分市场而不适用于另一个细分市场?

- 是否有可能使 loadstring 不可能等于打印?卢阿

- java中的random.expovariate()

- Appscript 通过会议在 Google 日历中发送电子邮件和创建活动

- 为什么我的 Onclick 箭头功能在 React 中不起作用?

- 在此代码中是否有使用“this”的替代方法?

- 在 SQL Server 和 PostgreSQL 上查询,我如何从第一个表获得第二个表的可视化

- 每千个数字得到

- 更新了城市边界 KML 文件的来源?