如何为Seq2Seq模型提供多个目标?

我正在对MSR-VTT数据集进行视频字幕。

在此数据集中,我有10,000个视频,并且对于每个视频,我都有20个不同的字幕。

我的模型由seq2seq RNN组成。编码器的输入是视频功能,解码器的输入是嵌入式目标字幕,解码器的输出是预测字幕。

我想知道是否多次使用相同的带有不同字幕的视频是否有用。

由于找不到明确的信息,因此我尝试对其进行基准测试

基准:

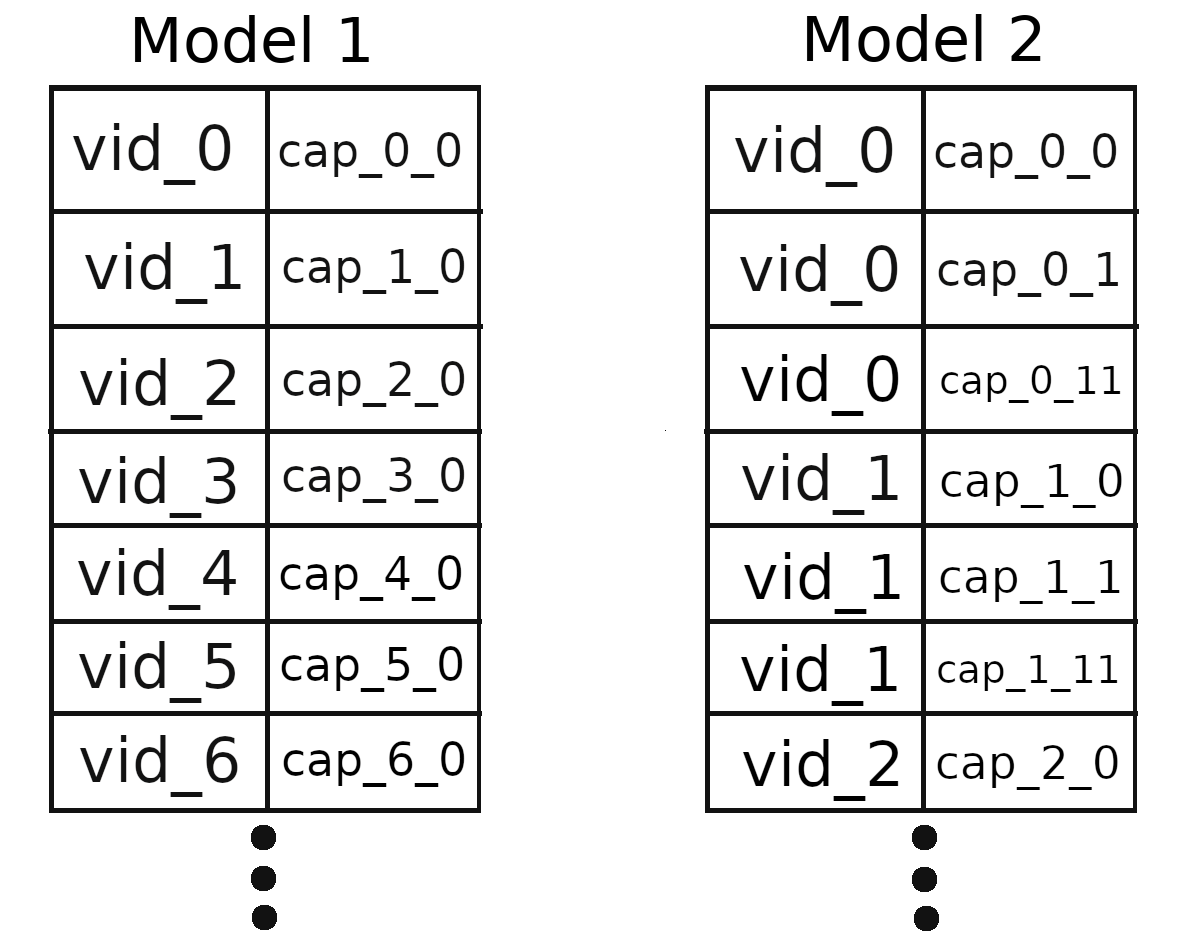

模型1:每个视频一个字幕

我在1108个体育视频中对其进行了培训,该视频的批次大小为5,超过60个纪元。此配置每个周期大约需要211秒。

Epoch 1/60 ; Batch loss: 5.185806 ; Batch accuracy: 14.67% ; Test accuracy: 17.64%

Epoch 2/60 ; Batch loss: 4.453338 ; Batch accuracy: 18.51% ; Test accuracy: 20.15%

Epoch 3/60 ; Batch loss: 3.992785 ; Batch accuracy: 21.82% ; Test accuracy: 54.74%

...

Epoch 10/60 ; Batch loss: 2.388662 ; Batch accuracy: 59.83% ; Test accuracy: 58.30%

...

Epoch 20/60 ; Batch loss: 1.228056 ; Batch accuracy: 69.62% ; Test accuracy: 52.13%

...

Epoch 30/60 ; Batch loss: 0.739343; Batch accuracy: 84.27% ; Test accuracy: 51.37%

...

Epoch 40/60 ; Batch loss: 0.563297 ; Batch accuracy: 85.16% ; Test accuracy: 48.61%

...

Epoch 50/60 ; Batch loss: 0.452868 ; Batch accuracy: 87.68% ; Test accuracy: 56.11%

...

Epoch 60/60 ; Batch loss: 0.372100 ; Batch accuracy: 91.29% ; Test accuracy: 57.51%

模型2:每个视频12个字幕

然后我训练了相同 1108个体育视频,批量大小为64。

此配置每个周期大约需要470秒。

由于每个视频都有12个字幕,因此我的数据集中的样本总数为1108 * 12。

这就是为什么我采用此批处理大小(64〜= 12 * old_batch_size)的原因。因此,这两个模型启动优化器的次数相同。

Epoch 1/60 ; Batch loss: 5.356736 ; Batch accuracy: 09.00% ; Test accuracy: 20.15%

Epoch 2/60 ; Batch loss: 4.435441 ; Batch accuracy: 14.14% ; Test accuracy: 57.79%

Epoch 3/60 ; Batch loss: 4.070400 ; Batch accuracy: 70.55% ; Test accuracy: 62.52%

...

Epoch 10/60 ; Batch loss: 2.998837 ; Batch accuracy: 74.25% ; Test accuracy: 68.07%

...

Epoch 20/60 ; Batch loss: 2.253024 ; Batch accuracy: 78.94% ; Test accuracy: 65.48%

...

Epoch 30/60 ; Batch loss: 1.805156 ; Batch accuracy: 79.78% ; Test accuracy: 62.09%

...

Epoch 40/60 ; Batch loss: 1.449406 ; Batch accuracy: 82.08% ; Test accuracy: 61.10%

...

Epoch 50/60 ; Batch loss: 1.180308 ; Batch accuracy: 86.08% ; Test accuracy: 65.35%

...

Epoch 60/60 ; Batch loss: 0.989979 ; Batch accuracy: 88.45% ; Test accuracy: 63.45%

这是我的数据集的直观表示:

我怎么解释这个结果?

当我手动查看测试预测时,模型2的预测看起来比模型1的预测更准确。

此外,我对Model 2使用的批处理大小为64。这意味着,通过选择较小的批处理大小可以获得更好的结果。似乎我没有更好的模式1训练方法,因为批量已经很小了

另一方面,模型1具有更好的损失和训练准确性结果...

我应该得出什么结论?

Model 2是否会不断用新的字幕覆盖以前训练过的字幕,而不是添加新的字幕?

1 个答案:

答案 0 :(得分:2)

由于我只使用了yolo之类的神经网络,所以不确定我是否正确理解了这一点,但这是我的理解: 您正在训练一个网络来字幕视频,现在您想为每个视频训练几个字幕,对吗?我想问题是您正在用新的字幕覆盖以前训练的字幕,而不是添加新的字幕。

您需要从一开始就训练所有可能的字幕,但是不确定网络架构是否支持此字幕。 使它正常工作有点复杂,因为您需要将输出与所有可能的字幕进行比较。同样,您可能需要使用20个最有可能的字幕作为输出,而不是仅使用一个以获得最佳结果。 恐怕我只能提供这种想法,因为我找不到很好的消息来源。

- 我写了这段代码,但我无法理解我的错误

- 我无法从一个代码实例的列表中删除 None 值,但我可以在另一个实例中。为什么它适用于一个细分市场而不适用于另一个细分市场?

- 是否有可能使 loadstring 不可能等于打印?卢阿

- java中的random.expovariate()

- Appscript 通过会议在 Google 日历中发送电子邮件和创建活动

- 为什么我的 Onclick 箭头功能在 React 中不起作用?

- 在此代码中是否有使用“this”的替代方法?

- 在 SQL Server 和 PostgreSQL 上查询,我如何从第一个表获得第二个表的可视化

- 每千个数字得到

- 更新了城市边界 KML 文件的来源?